Geçen haftanın sonlarında Apple, neredeyse herkesin iCloud fotoğraflarını tarayacak yeni bir çocuk istismarı karşıtı sistemi tanıttı. Her ne kadar fikir ilk bakışta kulağa hoş gelse de, çocukların gerçekten bu eylemden korunması gerektiğinden, Cupertino devi yine de çığ gibi eleştirildi - yalnızca kullanıcılar ve güvenlik uzmanları tarafından değil, aynı zamanda çalışanların kendi safları tarafından da.

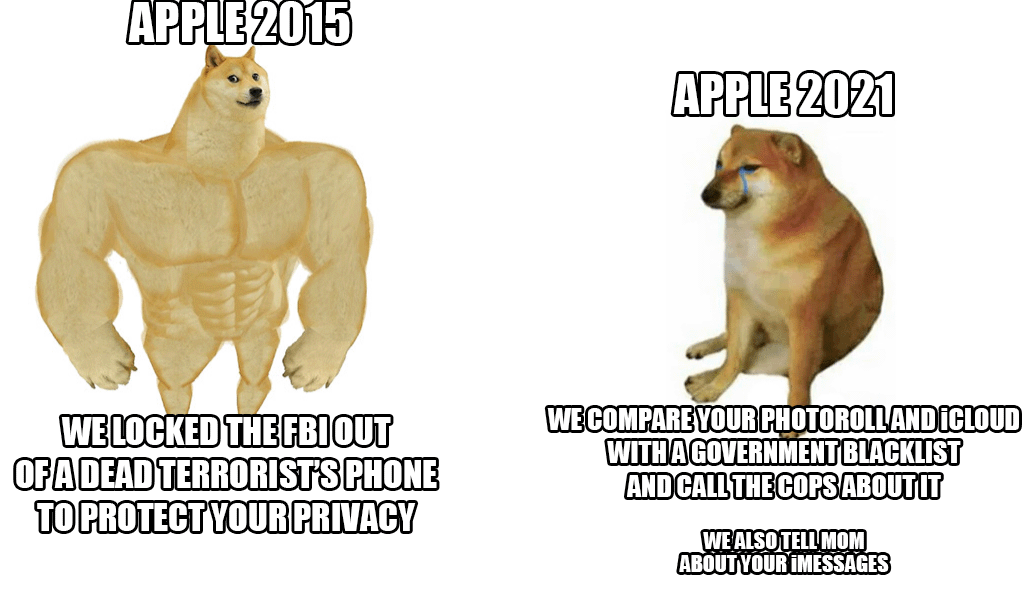

Saygın bir ajansın son bilgilerine göre reuters Birkaç çalışan, Slack üzerinden yapılan dahili bir iletişimde bu sistemle ilgili endişelerini dile getirdi. İddiaya göre, yetkililerin ve hükümetlerin bu olasılıkları kötüye kullanabilecekleri, örneğin insanları veya seçilmiş grupları sansürleyebilecekleri olası suiistimallerden korkmaları gerekiyor. Sistemin ortaya çıkışı, yukarıda bahsedilen Slack'te halihazırda 800'den fazla ayrı mesajın yer aldığı güçlü bir tartışmaya yol açtı. Kısacası çalışanlar endişeli. Hatta güvenlik uzmanları bile daha önce bunun yanlış ellere geçtiğinde aktivistleri bastırmak, bahsedilen sansür ve benzeri şeyleri bastırmak için kullanılan gerçekten tehlikeli bir silah olacağına dikkat çekmişti.

İyi haber (şimdiye kadar) yeniliğin yalnızca Amerika Birleşik Devletleri'nde başlayacak olmasıdır. Sistemin Avrupa Birliği ülkelerinde de kullanılıp kullanılmayacağı şu an için belli değil. Ancak tüm eleştirilere rağmen Apple tek başına duruyor ve sistemi savunuyor. Her şeyden önce, tüm kontrolün cihaz içinde gerçekleştiğini ve bir eşleşme olduğunda vakanın ancak o anda bir Apple çalışanı tarafından tekrar kontrol edildiğini savunuyor. Sadece kendi takdirine bağlı olarak ilgili makamlara teslim edilecektir.

Olabilir seninle ilgilenmek

iCloud'dan güvenli ve gerçekten özel bir şeye geçmek istemezdim ama Apple ısrar ederse yine de onlara ödeme yapmayı bırakacağım.

(Şimdilik) yalnızca ABD'de aktif olacak

Yasal olarak nerede uygulanacağı gerçekten önemli değil. Bu teknoloji zaten orada olacak ve konuşlandırılacak. En büyük risk bu.